フリー素材サイト「いらすとや」に出てくる人間風の画像を自動生成するモデルをDeep Learningで作りました。実装にはGoogle製のライブラリ「TensorFlow」と機械学習アルゴリズムの「DCGAN」「Wasserstein GAN」を用いています。

以下は生成された人間画像のうちそれなりにきれいなものの一例です。頬のところが赤くなっていて何となく本家いらすとやの特徴を捉えられていると思います。

「いらすとや」とは?

「いらすとや」は15,000種類以上のかわいいイラストを提供するフリー素材サイトです。皆さんもおそらく一度はどこかのWebページでいらすとやの画像が使われているのを見たことがあるのではないでしょうか。

実装した手法の概要

DCGAN、Wasserstein GANについて

人間画像生成モデルの学習にはDCGANとWasserstein GANを用いています。各アルゴリズムの詳細については既に他の方々が分かりやすい記事を書いていますのでそちらを参考にしてください。ここでは簡単な説明に留めます。

まず、GANはGenerative Adversarial Networkの略で、機械学習のアルゴリズムの一種です。「訓練データとGeneratorが生成したデータを見分けるDiscriminator」「Discriminatorを騙せるようなデータを出力するGenerator」を交互に競わせるように学習していき、最終的に訓練データに似たデータを生成できるGeneratorを作り上げることができます。

DCGANはDeep Convolutional GANの略で、GANを使いConvolutional Neural Network(CNN)を学習していく手法です。CNNを使うので画像生成に適用する事例が多いようです。論文ではBatch NormalizationやLeakyReLUといった工夫を用いることでGANによるCNNの学習が安定するとされています。

Wasserstein GANはGANの学習方法を改良したもので、Discriminator*1や目的関数を工夫することにより、GANの学習の収束しにくさやmode corruptionといった問題を軽減できるとされています。論文の著者本人がGithub上でPyTorchの実装を公開しています。

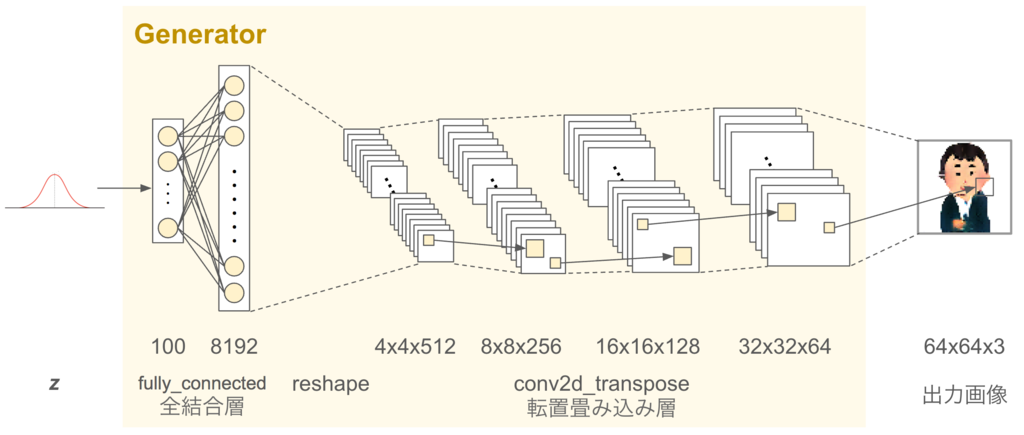

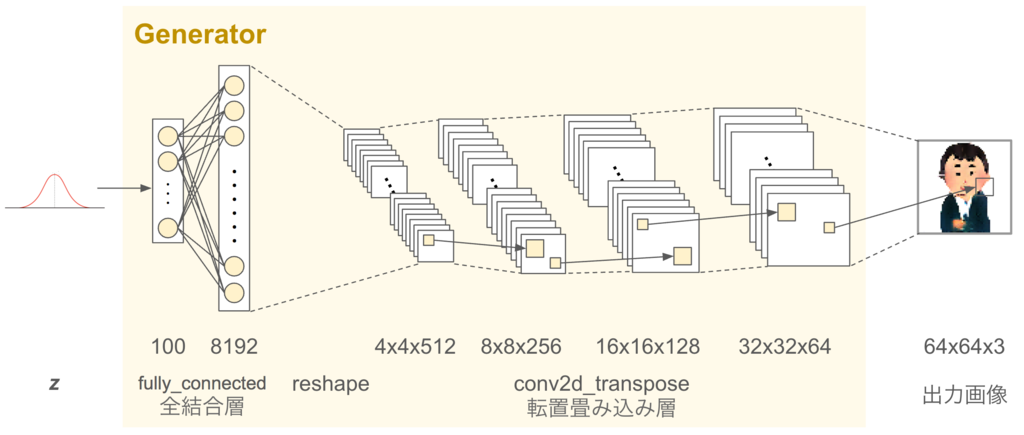

Generator

Generatorは「Discriminatorを騙せるようないらすとや風人間画像を出力するCNNベースのモデル」です。Generatorへの入力は標準正規分布*2からサンプルされた40次元の実ベクトルで、ひとつの入力ベクトルごとに対応するひとつの画像がモデルから出力されます。出力画像サイズは64x64で、各ピクセルのR、G、Bの値はそれぞれ[-1, 1]の範囲で表されます。このピクセル値を[0, 255]の範囲にリスケールすることで最終的な出力画像を得ることができます。

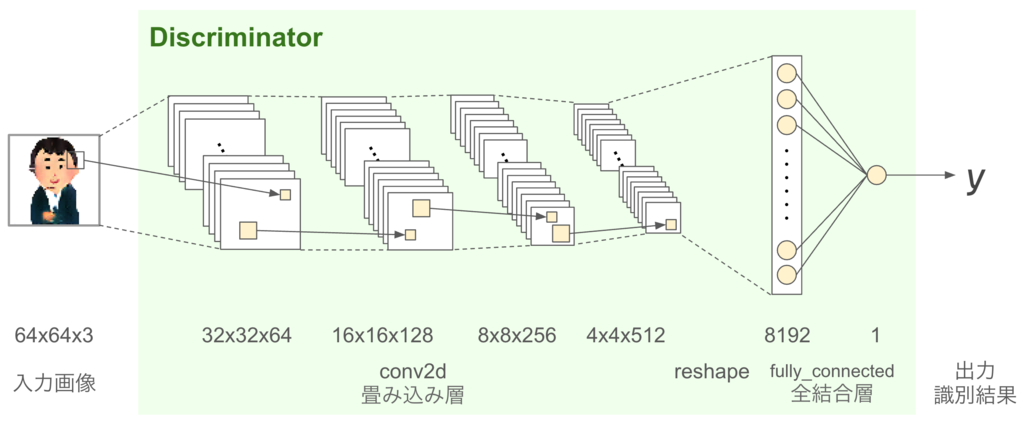

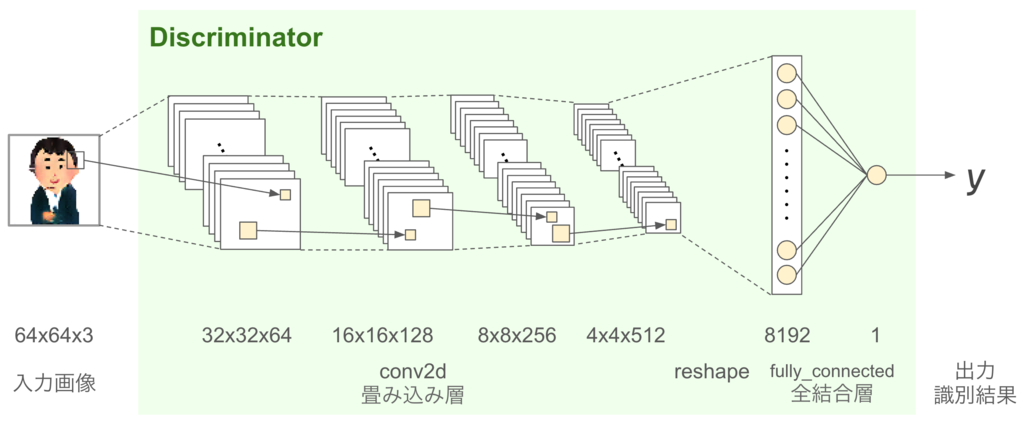

Discriminator

Discriminatorは「本物のいらすとやの画像とGeneratorが生成した画像を見分けることができるCNNベースのモデル」です。Discriminatorへの入力は64x64のRGB画像データです。各ピクセルのR、G、Bの値はそれぞれ[-1, 1]の範囲に正規化して入力します。出力はスカラー値で、Discriminatorが入力画像を本物のいらすとやの画像だと判定した場合は大きな値を、Generatorが生成した画像だと判定した場合は小さな値を出すように学習させます。

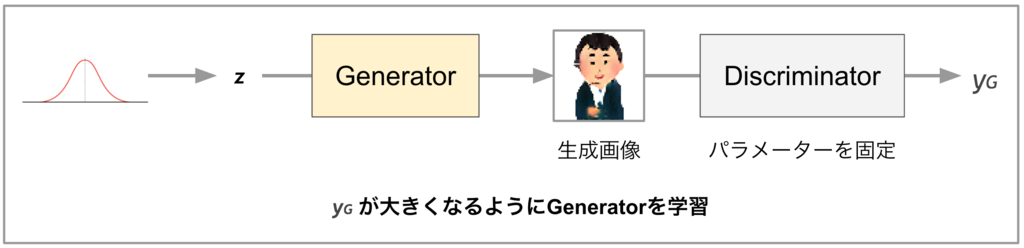

GeneratorとDiscriminatorの学習

DCGAN・Wasserstein GANでは、GeneratorとDiscriminatorを交互に学習させていきます。

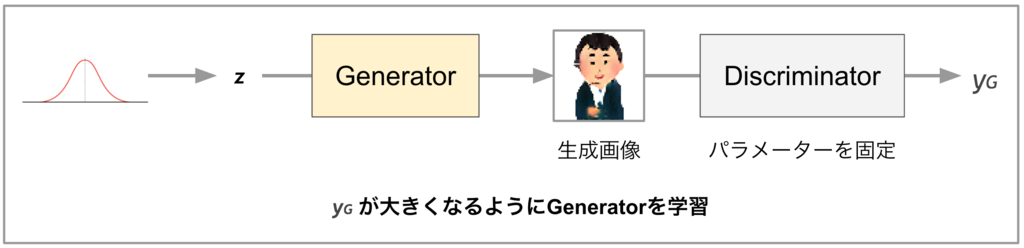

Generatorの学習の際にはDiscriminatorのパラメーターを固定し、以下の学習を行います。

- ベクトル

をサンプルしてGeneratorに与え、画像を出力する

をサンプルしてGeneratorに与え、画像を出力する

- Generatorの画像をDiscriminatorに与え、スカラー値

を出力する

を出力する

が大きな値となる画像を出力できるようにGeneratorのパラメーターを更新する

が大きな値となる画像を出力できるようにGeneratorのパラメーターを更新する

学習を続けていくと、理想的にはどんな入力ベクトル を与えてもDiscriminatorを騙せるくらい本物っぽい画像が出てくるようになります(しかし実際はそんなに甘くない)。

を与えてもDiscriminatorを騙せるくらい本物っぽい画像が出てくるようになります(しかし実際はそんなに甘くない)。

Discriminatorの学習時はGeneratorのパラメーターを固定し、以下の学習を行います。

- 訓練データからサンプルした本物のいらすとやの画像をDiscriminatorに与え、スカラー値

を出力する

を出力する

- ベクトル

をサンプルしてGeneratorに与え、画像を出力する

をサンプルしてGeneratorに与え、画像を出力する

- Generatorの画像をDiscriminatorに与え、

を出力する

を出力する

*3が大きな値となるようにDiscriminatorのパラメーターを更新する

*3が大きな値となるようにDiscriminatorのパラメーターを更新する

学習を続けていくと、理想的にはGeneratorがどんなに本物のいらすとやっぽい画像を出力するようになっても、Discriminatorは本物と偽物を見分けることができるようになります(しかし実際はそんなn)。

学習や実装の詳細

ネットワーク構成や各パラメーターは主にDCGANとWasserstein GANの論文を参考にしていて、あまり変わったことはしていないと思います。コードも他の方々がGithub等で公開しているものと同じような感じで実装しています。

Generator、Discriminatorのネットワーク構成やパラメーター

Generatorのネットワーク構成は以下のようになっています。

- 転置畳み込み層(conv2d_transpose)*4のカーネルサイズは4、ストライドは2です。

- Batch Normalizationは最初の全結合層と前3つの転置畳み込み層で適用しています。最後の転置畳み込み層では適用していません。

- 活性化関数は、最初の全結合層と前3つの転置畳み込み層ではReLUを適用しています。最後の転置畳み込み層では出力を[-1, 1]にするためにtanhを適用しています。

- dropoutは使っていません。

Discriminatorのネットワーク構成は以下のようになっています。

- 畳み込み層のカーネルサイズは4、ストライドは2です。

- Batch Normalizationは後ろ3つの畳み込み層で適用しています。最初の畳み込み層と最後の全結合層では適用していません。

- 活性化関数は、後ろ3つの畳み込み層ではLeakyReLUを適用しています。最初の畳み込み層と最後の全結合層では適用していません。

- プーリング層やdropoutは使っていません。

訓練データ

訓練データは約15,000枚のいらすとや画像をクロールし、「ひとりの人間が載っていて背景色などがあまり複雑でない画像」約4000枚を手動フィルターして使っています。訓練データ数が非常に少ないので、論文になっているようなDCGANの適用事例と比べると難易度が高いタスクではないかと思います。

その他

学習時のbatch sizeは64、最終的なtraining step数は149,560ですが、50,000 stepsあたりからそれ程精度の変化が見られませんでした。また、Wasserstein GANの論文に倣い、勾配法はRMSProp、学習率は0.00005、weight clippingパラメーターは0.01を使いました。

ちなみに手元のMacBook Pro Late 2016だと学習に時間がかかり過ぎたので、Google Cloud Platformの無料枠$300を使い、Cloud ML EngineのCPUx1+GPUx1のマシンで学習させたところ、学習速度が5倍以上になりました(それでも100k steps学習するのに1〜2日程度)。ハイパーパラメーターを調整して複数の学習を走らせることを考えると、やはり機械学習をする上でGPU等のある程度の計算資源は必須だと思います。

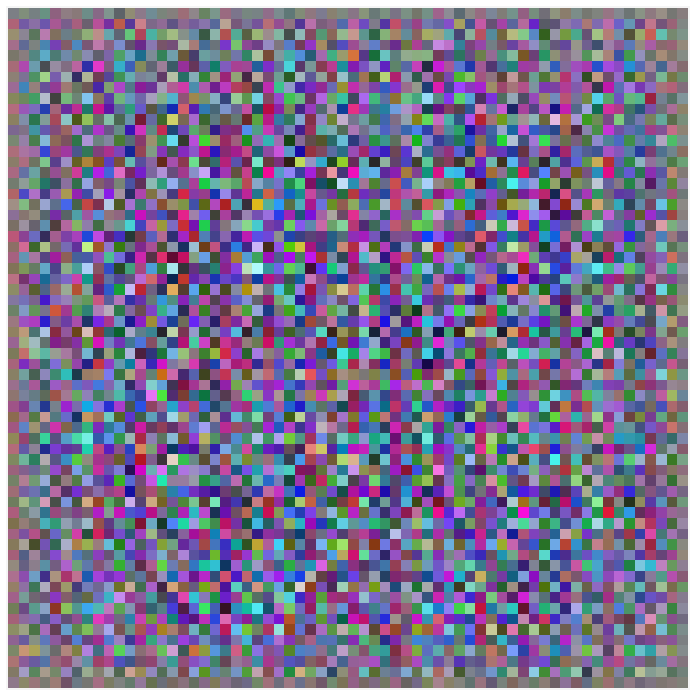

学習経過

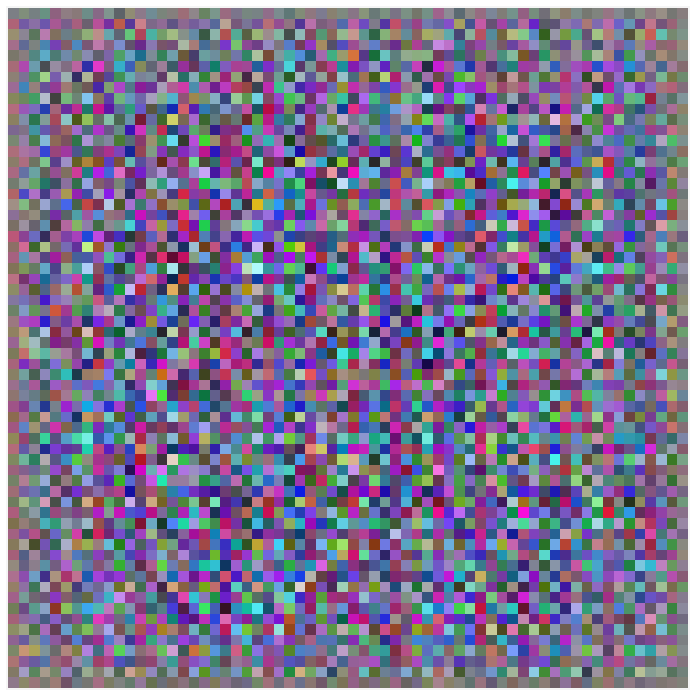

最初のうちはどんな入力に対してもランダムなモザイクのような画像が出力されます。

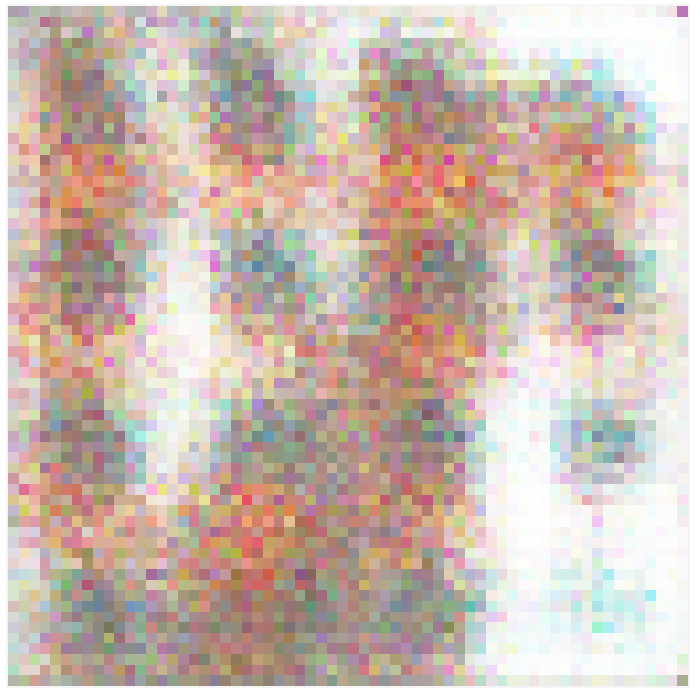

そこからだんだん出力画像が白くなっていき、1,000ステップあたりで髪の毛や人の肌っぽい色が目立ち始めてきます。しかし形は人間からは程遠いです。

1,500ステップくらいになるとより髪の色や肌っぽい色が強くなってきます。

4,000ステップくらいで何かしらの形が見え始めます。

7,000ステップくらいになると人の顔や髪の毛のような形が認識できるケースが増えてきます。

そこからしばらくは目や口みたいなものが顔みたいなものの中に現れたり、本当になんとも言えないぐちゃぐちゃなものが出力されたりと言った状況を繰り返します。50,000ステップくらいになると画像の粗さが減り、たまにいい感じの人間っぽい画像が出力されます。

だいたいこの時点で入力次第でモデルがいい画像を出力できるようになっていたようです。そこから先はあまり大きな変化は見られませんでした。

モデルを検証する

学習したモデルを手軽に確認してみるために、「TensorFlowによるDCGANでアイドルの顔画像生成 その後の実験など - すぎゃーんメモ」で紹介されているようなWeb UI(インスペクター)を実装し、様々な入力ベクトルに対応する出力画像を簡単に検証できるようにしてみました。以下はインスペクターでモデルを検証している時の動画です。

これを利用すれば、入力ベクトルのどの次元の値がどの画像の特徴を表しているのかが分かる…かもしれません。

ちなみに学習時の入力ベクトルは標準正規分布からサンプルしているので、ゼロベクトルに対応する出力画像は全ての人間画像の中間表現みたいになるのかなと思って見てみたら以下のような筆舌に尽くし難い画像が出てきました。

中間人間画像が必要な方はご自由にお使いください。

入力にバイアスを掛けていい画像を出やすくする

学習したモデルに適当な入力ベクトルを与えても、必ずしもきれいな画像が出てくるとは限りません。

DCGANなどの論文ではよく本物の写真みたいな画像が生成された例が出てくると思いますが、あれらもいい画像が出てくるまで入力を変えて頑張り続けた結果だと思います。

そこで、「TensorFlowによるDCGANでアイドルの顔画像生成 その後の実験など - すぎゃーんメモ」で紹介されているように、入力ベクトルにバイアスを掛けてモデルがいい画像だけを出力しやすくなるようにできるか試してみました。まず、いい画像が出るまでランダムな入力ベクトルをモデルに与え、画像を生成し続けます。そして、以下のようなよさげな画像が出たところで…、

その画像の入力ベクトルを保持しておきます。

[-1.0,-0.6,-0.8,-0.1,1.1,-0.7,-1.6,-1.1,0.8,0.1,-0.2,0.1,0.8,0.6,1.1,-0.9,-0.4,0.9,2.0,0.8,1.5,2.1,-2.5,1.4,-0.1,1.6,-1.0,0.2,-0.8,-0.6,-1.0,0.4,-0.6,-0.2,0.1,0.1,1.6,0.0,0.7,-0.4]

そして、それに標準偏差が小さめ(σ=0.5くらい)の正規分布からサンプルしたベクトルを加えて人間画像生成モデルに与えます。すると、以下のようにきれいで何となく元画像に似ているものが生成されます。

このように、いい画像が生成された時のベクトル周辺だけを入力として与えるようにすればきれいな画像だけが出力されやすくなりますが、その代わり出力画像は元画像に似たようなものが多くなりバリエーションは減ってしまいます。難しいところです。

ちなみにσ=0.7の正規分布からサンプルしたベクトルを加えると、より画像の変化は大きくなりましたが人間の首が千切れたりし始めました。

まとめ

機械学習アルゴリズム「DCGAN」「Wasserstein GAN」を使い、いらすとや風人間画像生成モデルを実装しました。入力次第ではそれっぽい画像が生成できるようになったので、Google Cloud Platformの無料枠$300をすべてつぎ込んで色々試した甲斐があったのではないかと思います。

本当は各いらすとやの画像タイトルとConditional GANを使い、入力ベクトルとラベル("誕生日"、"人工知能"など)をモデルに与えるとそのラベルに対応した画像を出力するモデルをつくりたかったのですが、各ラベルに対する訓練データが少なすぎるので一旦断念しました。機会があれば試してみたいところです。

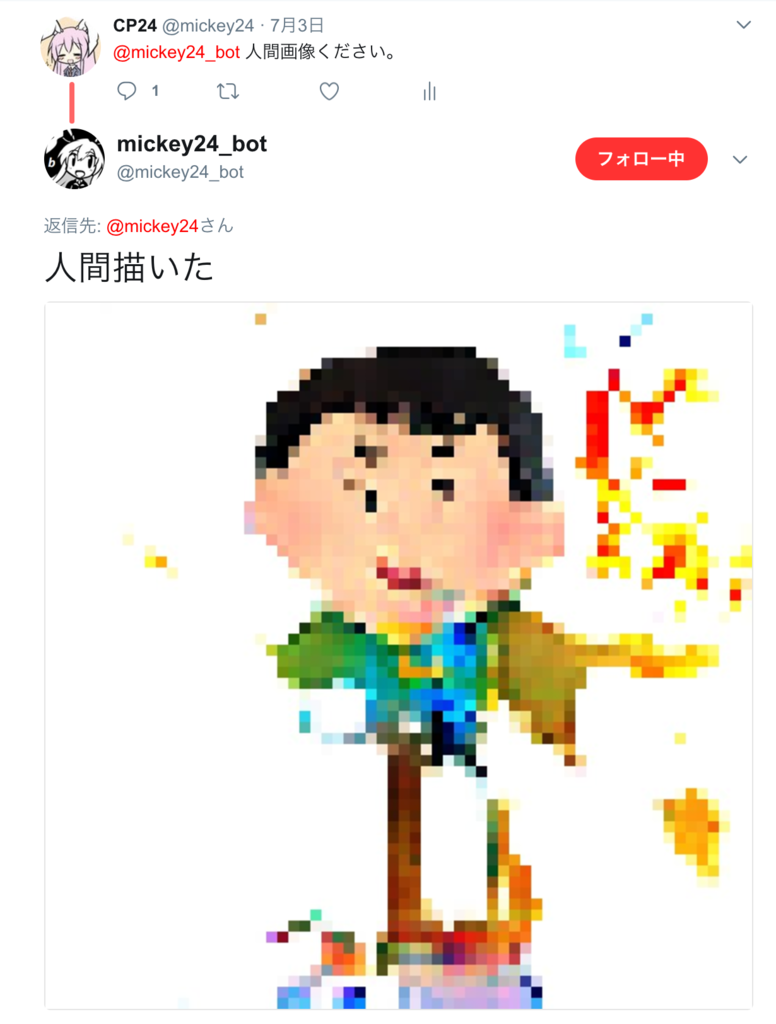

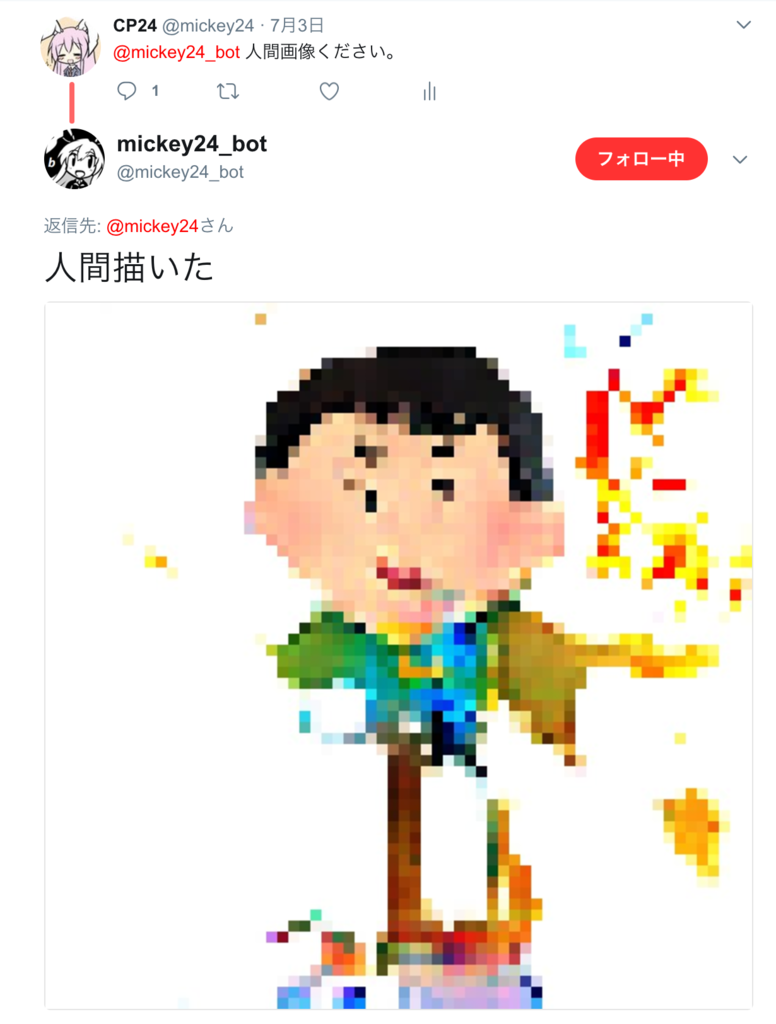

今回出来上がった人間画像生成モデルに興味がある方は、Twitterでmickey24_botに「人間画像ください」と話しかけると手軽に試すことが出来ます。ただしうちのbotはランダムな入力ベクトルを基に画像を生成するので、ほとんどの場合すり潰された人間のような画像が出てきますがご了承ください。

参考文献(サイト)